Mis à jour le 17 septembre 2025

Le crawl est la pierre angulaire de toute stratégie de SEO technique. Avant qu’une page ne soit indexée puis positionnée dans les résultats de recherche, elle doit être explorée par les robots des moteurs, notamment Googlebot. Un site mal exploré est un site mal indexé et donc un site peu visible.

De nombreux sites, parfois bien conçus en apparence, présentent pourtant un défaut critique : une mauvaise gestion de l’exploration. Cela conduit à une sous-indexation des pages importantes, un gaspillage du budget de crawl, et une perte de visibilité organique.

Ce guide propose une lecture complète et opérationnelle des enjeux liés au crawl. Il vous aidera à comprendre son fonctionnement, à détecter les freins invisibles, et à déployer des actions concrètes pour améliorer la découvrabilité de vos contenus.

Comprendre le crawl en SEO

Le crawl désigne le processus par lequel les robots d’indexation, comme Googlebot, parcourent un site web afin d’en analyser la structure, les contenus et la performance technique. Cette étape précède l’indexation, elle-même indispensable pour apparaître dans les résultats de recherche.

Lorsqu’un robot explore un site, il suit les liens internes et externes, lit le code HTML des pages, collecte des données sur la performance (temps de chargement, erreurs, profondeur), et détermine la pertinence des contenus. Plus l’exploration est fluide et structurée, plus l’indexation est complète et efficace.

Le budget de crawl : une ressource limitée

Google alloue à chaque site un budget de crawl, c’est-à-dire un volume maximum de pages que ses robots peuvent explorer sur une période donnée. Ce budget est influencé par plusieurs facteurs :

- La notoriété et l’autorité du site

- La fréquence de mise à jour du contenu

- La vitesse de réponse du serveur

- Le taux d’erreur rencontré par les robots

- L’architecture du site

Une mauvaise gestion du crawl peut entraîner :

- La non-exploration de pages importantes

- L’exploration excessive de pages sans valeur SEO

- Une couverture d’indexation incomplète

L’objectif est donc de canaliser les efforts de Googlebot vers les pages à fort potentiel, tout en limitant l’accès aux contenus secondaires ou inutiles.

Bonnes pratiques pour optimiser le crawl de votre site

Structurer le site pour faciliter l’exploration

Un site bien organisé permet aux robots d’atteindre rapidement les contenus stratégiques. Voici les principes fondamentaux :

- Maintenir une profondeur de clics raisonnable (idéalement ≤ 3)

- Concevoir un maillage interne logique, avec des liens pertinents entre les pages

- Créer un sitemap XML à jour, contenant uniquement les pages à indexer, et le soumettre dans Google Search Console

Contrôler l’accessibilité aux robots

Deux outils majeurs permettent de gérer ce que les robots peuvent explorer ou indexer :

1. Le fichier robots.txt

Il sert à bloquer certaines parties du site de l’exploration. Il doit être configuré avec rigueur pour éviter de bloquer accidentellement des contenus importants.

2. Les balises meta robots

Elles permettent d’indiquer si une page doit être indexée ou non (noindex), et si les liens doivent être suivis (nofollow). Privilégiez le noindex, follow pour les pages peu utiles à l’index, tout en conservant le maillage interne.

Attention également aux URLs dynamiques avec paramètres qui génèrent des duplications explorées inutilement. Il est souvent nécessaire de les filtrer via Search Console ou des règles spécifiques dans robots.txt.

Supprimer les freins techniques

Certains éléments techniques peuvent limiter ou ralentir l’exploration :

- Redirections multiples ou en chaîne

- Liens cassés (erreurs 404)

- Erreurs serveur (codes 500)

- Temps de chargement élevé

- Contenus chargés exclusivement en JavaScript non interprétable

Un audit SEO technique régulier permet d’identifier et de corriger ces problèmes. L’utilisation d’outils comme Screaming Frog ou OnCrawl est fortement recommandée pour simuler l’exploration par Googlebot.

Prioriser les pages stratégiques

Tous les contenus d’un site n’ont pas la même valeur. Il est essentiel de concentrer les efforts de crawl sur les pages à forte valeur ajoutée :

- Pages à fort potentiel SEO (requêtes à volume élevé ou à forte intention)

- Pages génératrices de trafic ou de conversions

- Pages en phase de mise à jour stratégique

À l’inverse, il peut être pertinent de restreindre ou d’exclure du crawl les contenus suivants :

- Archives anciennes sans trafic

- Résultats de recherche interne

- Pages de filtres ou de tri

- Variantes de produits sans contenu différencié

L’optimisation passe par une hiérarchisation claire du site, où les pages les plus importantes sont facilement accessibles, régulièrement mises à jour et bien intégrées au maillage.

Analyser et suivre le comportement de Googlebot

L’analyse du comportement de Googlebot est indispensable pour évaluer l’efficacité de vos actions. Plusieurs outils permettent d’obtenir des données fiables :

Google Search Console

Il offre une vue détaillée sur :

- Le volume de pages explorées par jour

- Les types de réponses serveur rencontrées

- Le temps de réponse moyen

- Les pages récemment explorées

Outils de crawl SEO

Des logiciels comme Screaming Frog, OnCrawl ou Botify simulent l’exploration de votre site par un robot. Ils permettent de visualiser l’arborescence, d’identifier les contenus orphelins, les problèmes de duplication ou les goulets d’étranglement dans le maillage.

Aller plus loin : croiser technique et visibilité avec Ranxplorer

L’analyse du crawl ne suffit pas à elle seule. Elle doit être complétée par une analyse de la performance réelle des contenus dans les SERP.

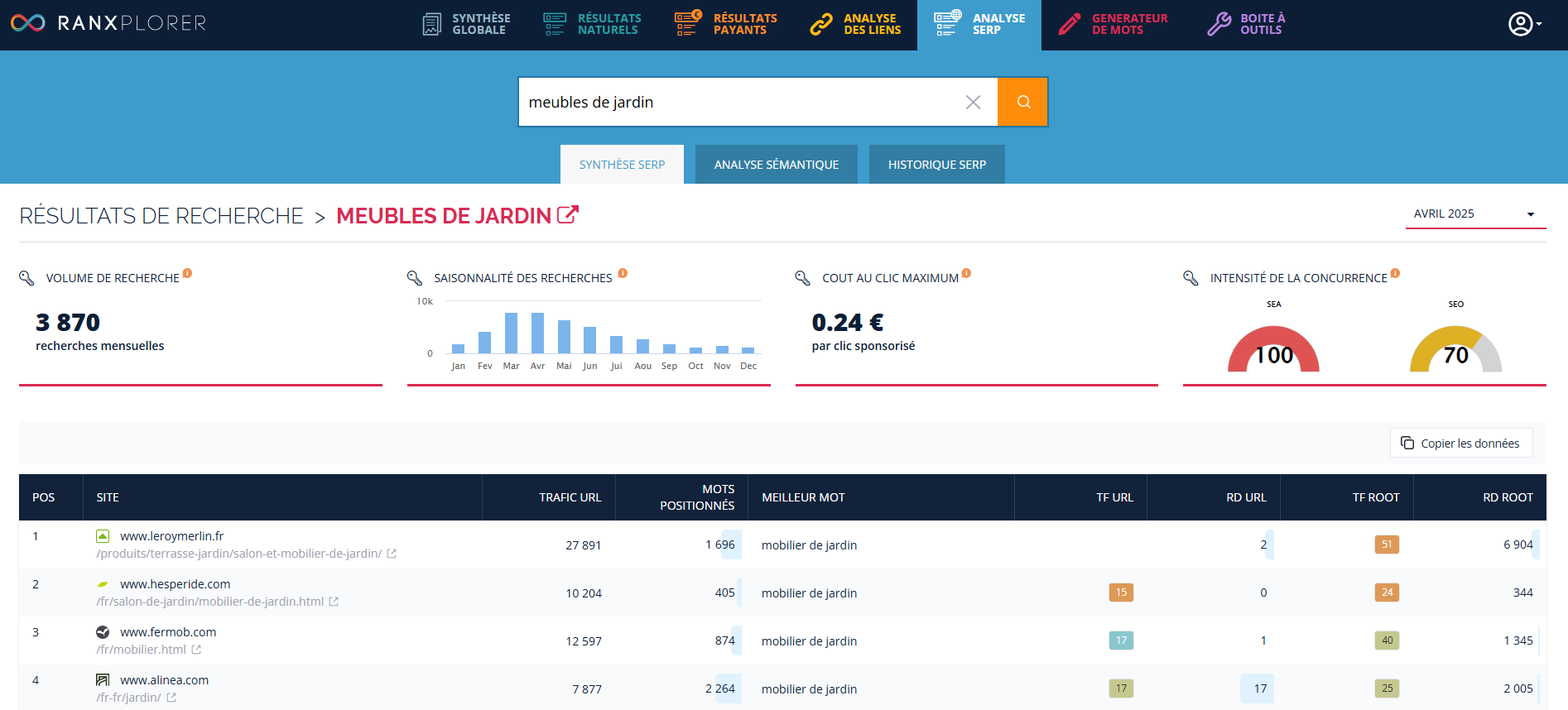

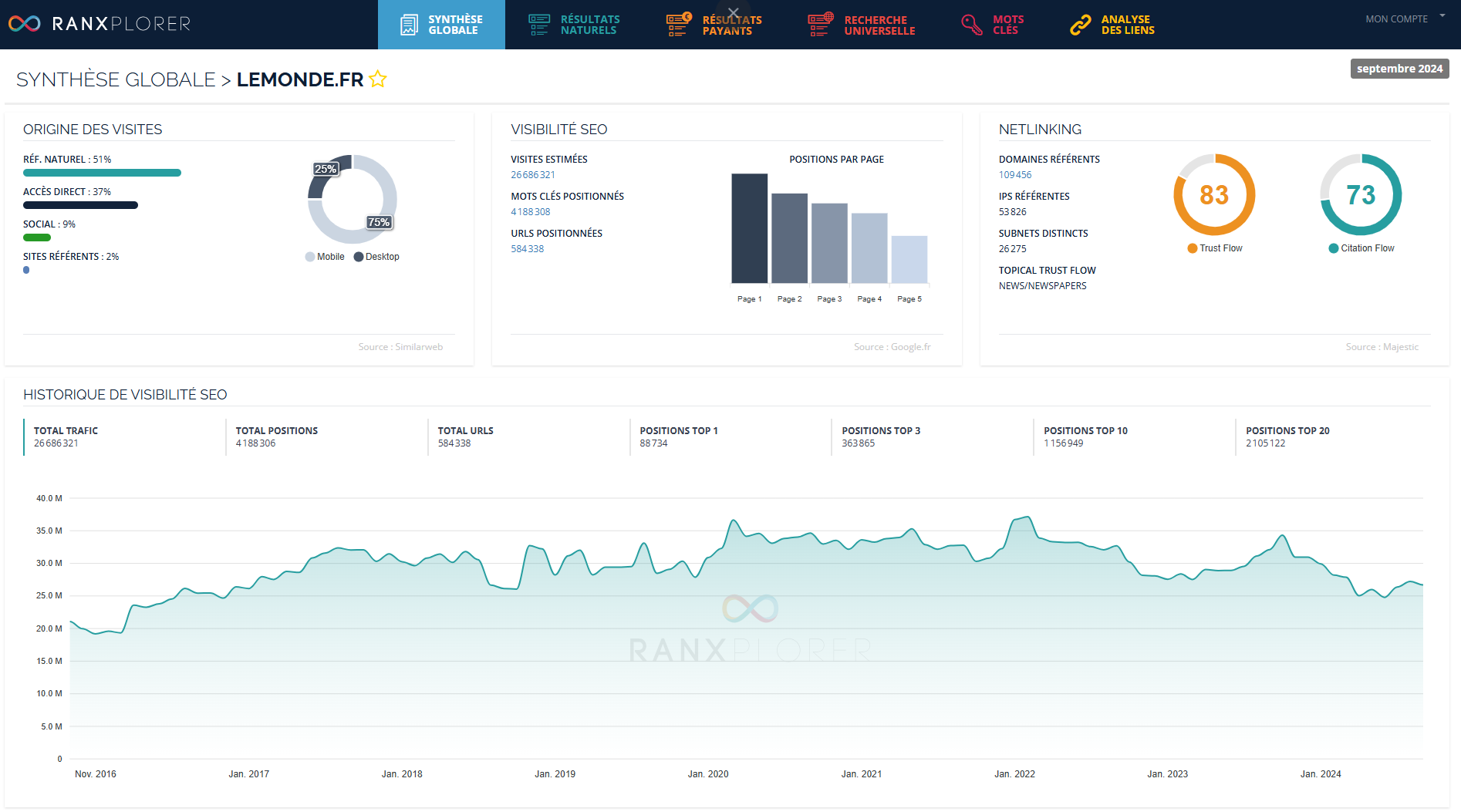

Ranxplorer, bien que non dédié au crawl, permet d’enrichir la stratégie SEO à travers des données de positionnement :

- Suivi des mots-clés sur lesquels le site est positionné

- Analyse des pages qui génèrent (ou non) du trafic organique

- Détection des pages sous-exploitées, malgré un bon potentiel SEO

- Identification des opportunités de contenus

En croisant les données issues d’un audit de crawl avec celles de Ranxplorer, vous pouvez :

- Identifier les pages explorées, mais non performantes

- Renforcer le maillage interne vers les contenus à optimiser

- Décider de désindexer proprement certaines pages

- Réorienter le budget de crawl vers les URLs les plus stratégiques

Cette approche croisée permet d’aligner les efforts techniques avec les objectifs de visibilité.

Conclusion

Optimiser le crawl SEO, c’est offrir à Googlebot un accès rapide, structuré et sans obstacle à vos contenus. Cela demande une maîtrise des fondamentaux techniques, une stratégie de contenu réfléchie et une vision claire de la performance organique du site.

En combinant des outils d’analyse de crawl et des plateformes SEO comme Ranxplorer, vous alignez vos efforts techniques et stratégiques. Le résultat : un site mieux indexé, plus visible, et plus performant en référencement naturel.